https://docs.google.com/presentation/d/e/2PACX-1vRsFa599JedNi-amKMpoR_tXsFqTdLOLkpqGIcy4_FkrX-IHZMGmEeSLDRiEgspqw/pubembed?start=false&loop=false&delayms=3000

A Inteligência Artificial Explicável (XAI) surge como resposta à crescente necessidade de compreender e confiar em sistemas de aprendizado de máquina que operam como “caixas-pretas”. Frameworks e ferramentas de XAI possibilitam tanto o desenvolvimento de modelos intrinsecamente interpretáveis quanto a aplicação de métodos post-hoc para gerar explicações claras sobre como e por que determinadas decisões são tomadas. Em domínios críticos como saúde, finanças e veículos autônomos, a transparência algorítmica é fundamental para garantir segurança, responsabilidade e conformidade regulatória.

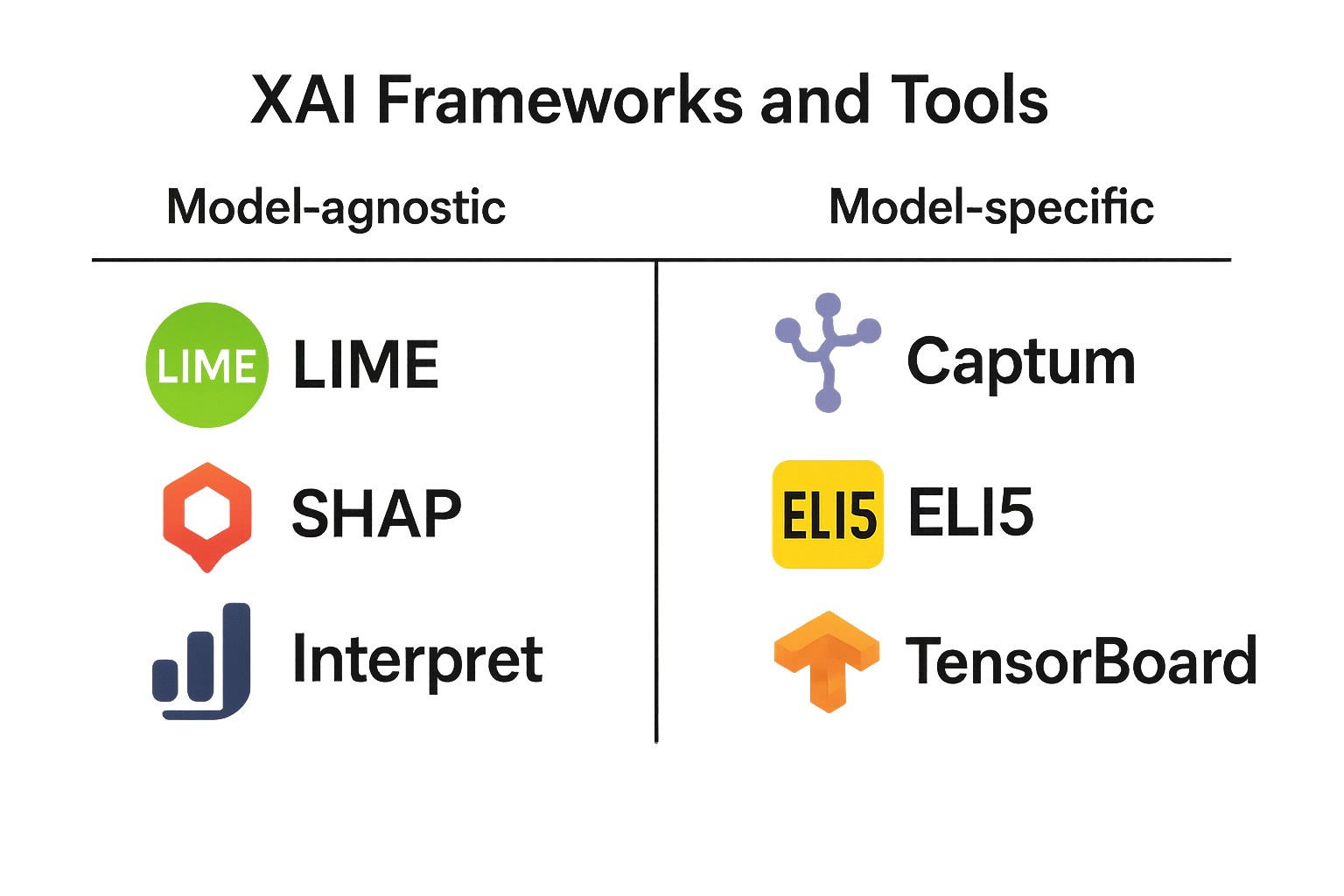

Os frameworks de XAI podem ser classificados segundo diversos critérios, mas um dos mais didáticos é a distinção entre métodos:

Model-Agnostic (agnósticos ao modelo)

Oferecem explicações que podem ser aplicadas a qualquer tipo de modelo (por exemplo, LIME e SHAP)12.

Model-Specific (específicos ao modelo)

Aproveitam peculiaridades de determinadas arquiteturas para gerar explicações precisas (por exemplo, Grad-CAM para CNNs)3.

Intrínsecos (pre-hoc)

Modelos projetados desde o início para serem interpretáveis, como Explainable Boosting Machines (EBM) do InterpretML4.

Post-hoc

Técnicas aplicadas após o treinamento que analisam o comportamento do modelo, sem alterar sua estrutura, como Integrated Gradients em Captum5.

Esquema dos principais frameworks e ferramentas de XAI

Esquema dos principais frameworks e ferramentas de XAI.

O AI Explainability 360 é um toolkit open-source que reúne mais de dez algoritmos de explicação, incluindo métodos de raciocínio baseado em exemplos, regras interpretáveis, explicações locais e globais. Fornece também métricas como faithfulness e monotonicity para avaliar a qualidade das explicações em diferentes cenários, desde crédito até medicina67.

O Alibi é uma biblioteca Python voltada para produção, oferecendo suporte a métodos model-agnostic e model-specific em dados tabulares, texto e imagens. Sua API unificada abrange explicações locais e globais, além de integrar-se a plataformas de deployment como Seldon Core e KFServing8.

Desenvolvido pelo time do PyTorch, o Captum fornece implementações de algoritmos de atribuição de características (Integrated Gradients, Saliency Maps, SmoothGrad), além de módulos de visualização (captum.attr.visualization) e um dashboard interativo (Captum Insights). É especialmente indicado para pesquisadores que trabalham com modelos profundos em PyTorch59.