https://docs.google.com/presentation/d/e/2PACX-1vRuFnZbaGt4cKut45FGw-DbmN8XaF_k9g7O7YoShpQ--uOevsJzctw1xUcaki3oXg/pubembed?start=false&loop=false&delayms=3000

A transparência em inteligência artificial representa uma das questões mais fundamentais e complexas do desenvolvimento tecnológico contemporâneo1. Desde os primeiros sistemas especialistas dos anos 1970 até as regulamentações mais rigorosas de 2024, a busca por sistemas de IA compreensíveis e confiáveis tem moldado a trajetória desta tecnologia transformadora23. Esta evolução não é apenas técnica, mas reflete profundas mudanças sociais, éticas e regulatórias que definem como a humanidade se relaciona com sistemas automatizados cada vez mais poderosos45.

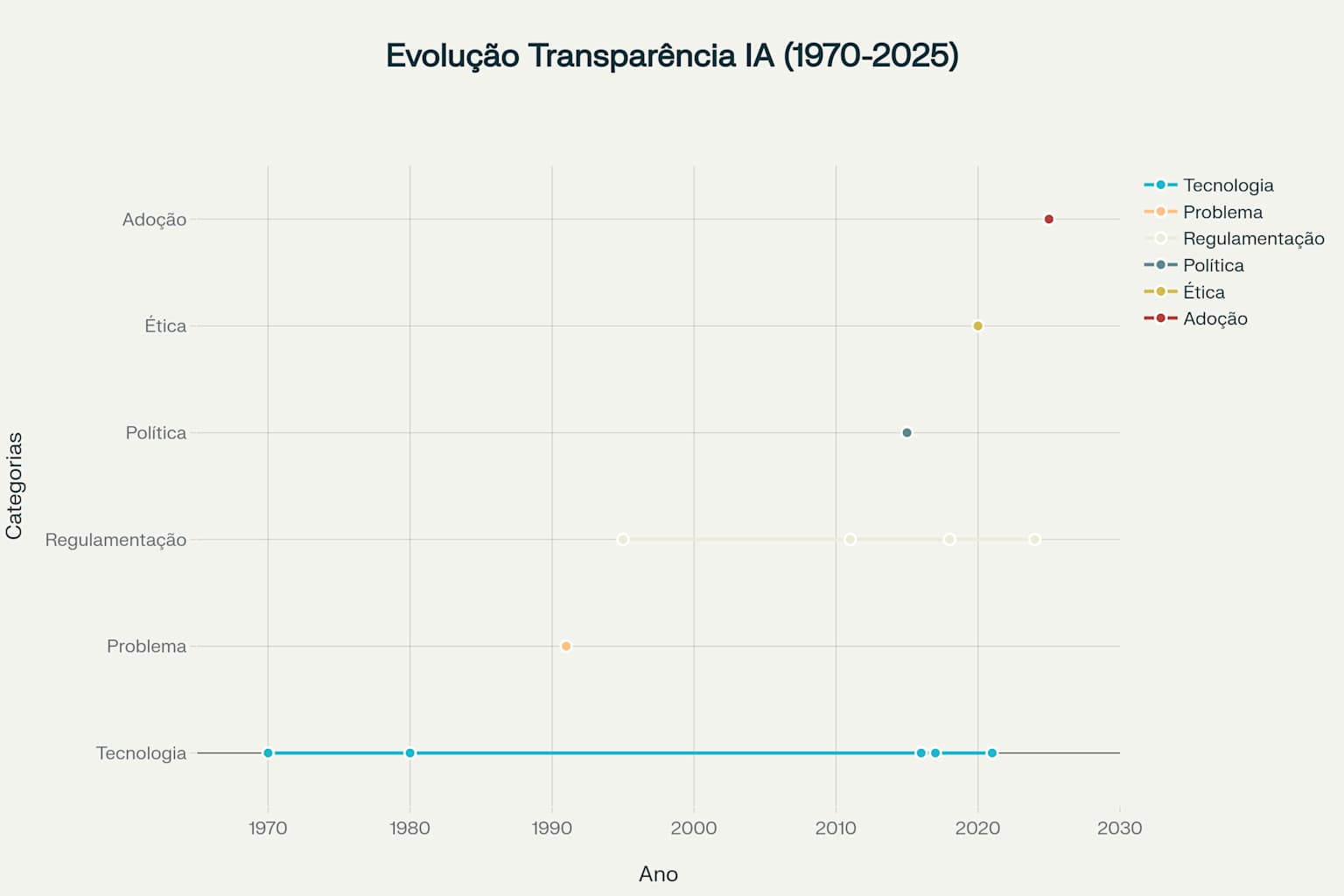

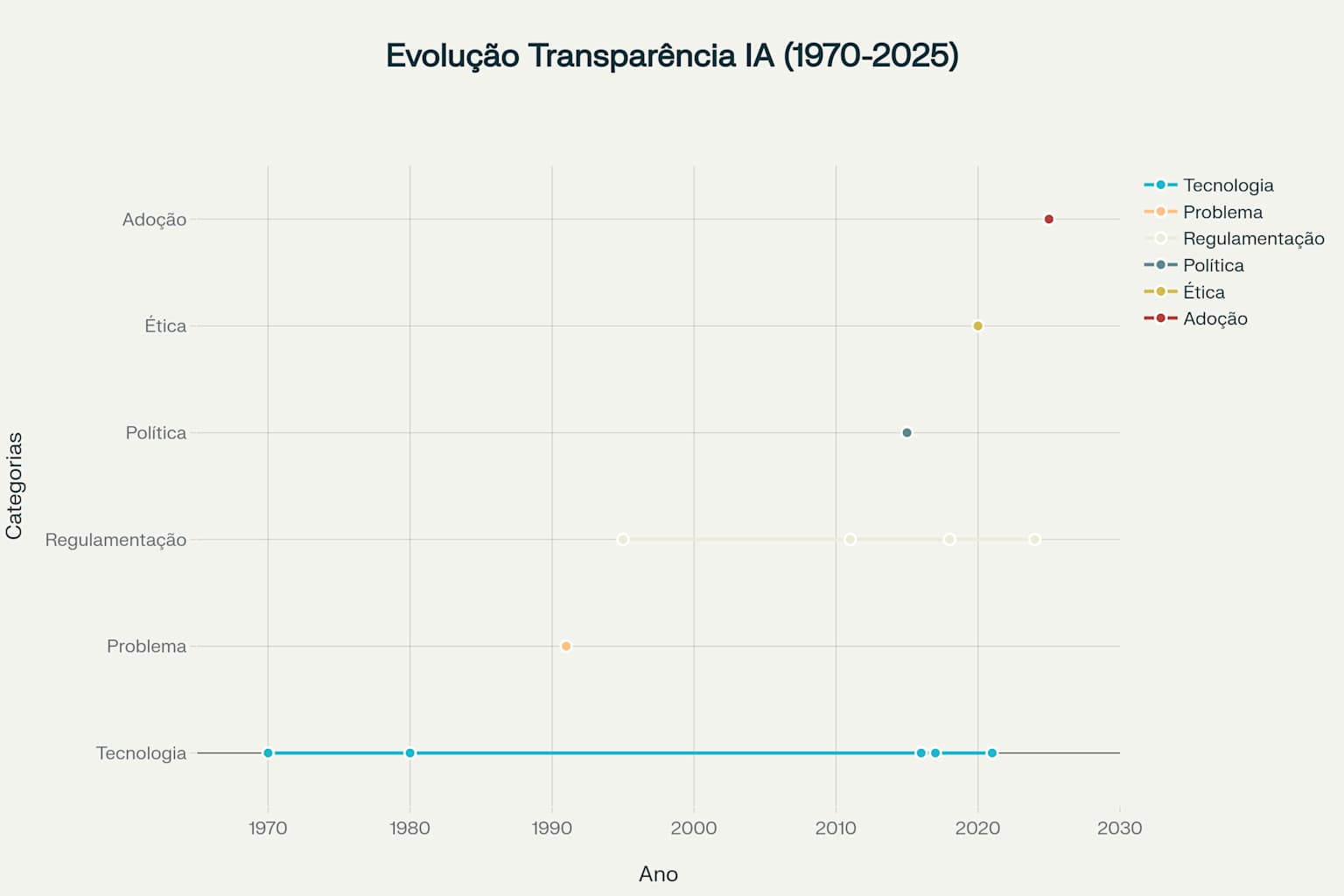

Linha do tempo mostrando marcos históricos na evolução da transparência em IA desde 1970

A primeira era da transparência em IA caracterizou-se pela transparência inerente dos sistemas especialistas67. Estes sistemas baseavam-se em regras explícitas definidas por especialistas humanos, tornando suas decisões naturalmente interpretáveis89. O sistema MYCIN, desenvolvido entre 1972 e 1980, exemplifica perfeitamente esta abordagem ao assistir médicos no diagnóstico de doenças infecciosas através de regras claras e rastreáveis7. A separação entre base de conhecimento e motor de inferência permitia que os usuários compreendessem exatamente como as conclusões eram alcançadas6.

Durante este período, a explicabilidade não era um objetivo adicional, mas uma característica fundamental da arquitetura dos sistemas3. As limitações computacionais da época também contribuíam para esta transparência, pois os sistemas precisavam ser relativamente simples para serem viáveis9. Aproximadamente dois terços das empresas Fortune 500 utilizavam sistemas especialistas nos anos 1980, demonstrando sua ampla adoção e confiabilidade7.

A segunda era manteve o foco em modelos interpretáveis como árvores de decisão e regressão linear8. Estes algoritmos ofereciam um equilíbrio entre capacidade preditiva e transparência, permitindo que usuários compreendessem as regras de decisão através de estruturas visuais claras2. As árvores de decisão, em particular, forneciam caminhos de decisão facilmente seguíveis, onde cada nó representava uma pergunta específica sobre os dados8.

O principal desafio desta era residia no trade-off entre simplicidade e performance8. Modelos mais complexos frequentemente ofereciam maior precisão, mas sacrificavam a interpretabilidade10. Esta tensão começou a sinalizar os desafios que se intensificariam na era seguinte, quando algoritmos mais sofisticados emergiriam9.

A terceira era marcou uma revolução e uma crise na transparência de IA11. O advento do deep learning trouxe capacidades sem precedentes em reconhecimento de imagens, processamento de linguagem natural e outros domínios complexos8. Entretanto, estes avanços vieram acompanhados de uma opacidade fundamental nos processos de tomada de decisão11.

O incidente de Dean Pomerleau em 1991, embora anterior a esta era, prenunciou o problema central: um sistema de direção autônoma que funcionava bem até falhar inexplicavelmente ao aproximar-se de uma ponte11. A investigação posterior revelou que o sistema havia aprendido a usar a grama das margens da estrada como guia, estratégia que falhou quando encontrou o ambiente diferente da ponte11. Este caso ilustra perfeitamente o problema da black box: sistemas que funcionam bem na maioria dos casos mas falham de formas incompreensíveis11.

A quarta era representou uma resposta sistemática ao problema da opacidade1012. Em 2015, a DARPA formulou o programa Explainable AI (XAI) com o objetivo de permitir que usuários finais compreendessem, confiassem e gerenciassem efetivamente sistemas de IA12. Este programa de quatro anos, que começou em 2017 e terminou em 2021, investiu US$ 50 milhões no desenvolvimento de técnicas de explicabilidade813.

O desenvolvimento de técnicas post-hoc revolucionou a área1415. LIME (Local Interpretable Model-agnostic Explanations), introduzido em 2016, permitiu explicações locais de qualquer modelo através da aproximação com modelos interpretáveis14. SHAP (SHapley Additive exPlanations), desenvolvido em 2017, trouxe rigor matemático baseado na teoria dos jogos para atribuir valores de importância às características15.

A quinta e atual era estabeleceu a transparência como requisito legal e ético obrigatório1617. O GDPR, que entrou em vigor em 2018, estabeleceu o "direito à explicação" para decisões automatizadas que afetam indivíduos1819. O EU AI Act de 2024 representa o primeiro marco regulatório abrangente, exigindo transparência obrigatória para sistemas de IA de alto risco1620.

Esta era caracteriza-se pela convergência de pressões técnicas, sociais e regulatórias2122. Organizações globais reconhecem que a transparência não é mais opcional, mas essencial para manter a licença social para operar234. A IA responsável tornou-se um imperativo de negócios, não apenas uma consideração ética2425.