https://docs.google.com/presentation/d/e/2PACX-1vTrxdPCgDL0gEu4xdh7ufrY6zIj0VxRKbGOII4CETD473j6_L6xDaAEvqlzIFjsog/pubembed?start=false&loop=false&delayms=3000

A Inteligência Artificial Explicável (XAI) em diagnóstico médico representa uma revolução paradigmática na medicina moderna, onde a transparência algorítmica torna-se não apenas desejável, mas essencial para a confiança clínica e segurança do paciente12. Com o avanço dos sistemas de aprendizado profundo em aplicações médicas, a necessidade de compreender como e por que os modelos chegam a determinadas conclusões diagnósticas tornou-se crítica para aceitação profissional e conformidade regulatória34.

A aplicação de IA em diagnóstico médico já demonstra capacidade de superar a precisão de radiologistas humanos em tarefas específicas, como detecção de câncer de mama em mamografias2 e análise de radiografias torácicas3. Contudo, esta superioridade técnica só se traduz em benefício clínico quando acompanhada de explicabilidade que permita aos profissionais validar, confiar e complementar as decisões algorítmicas56.

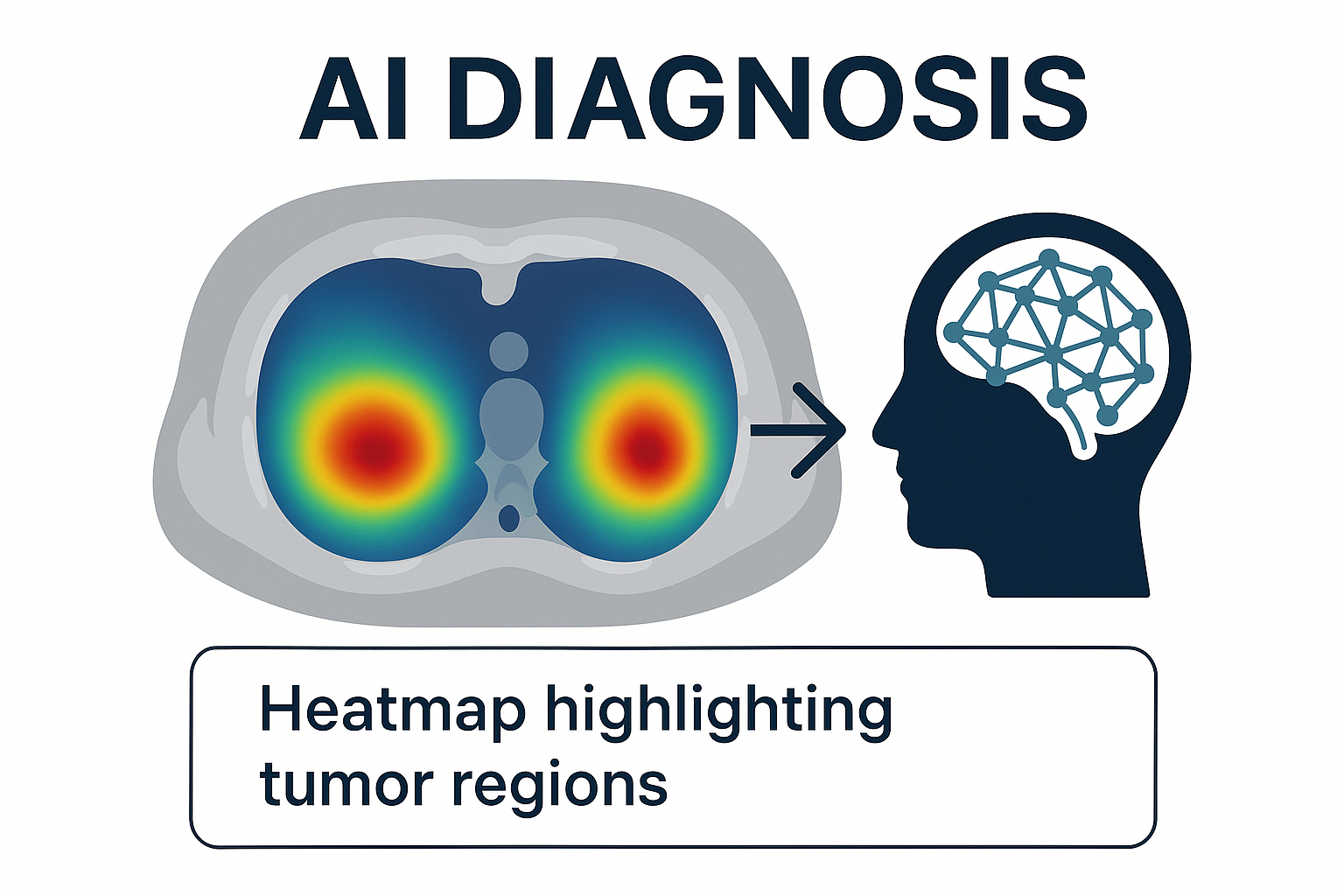

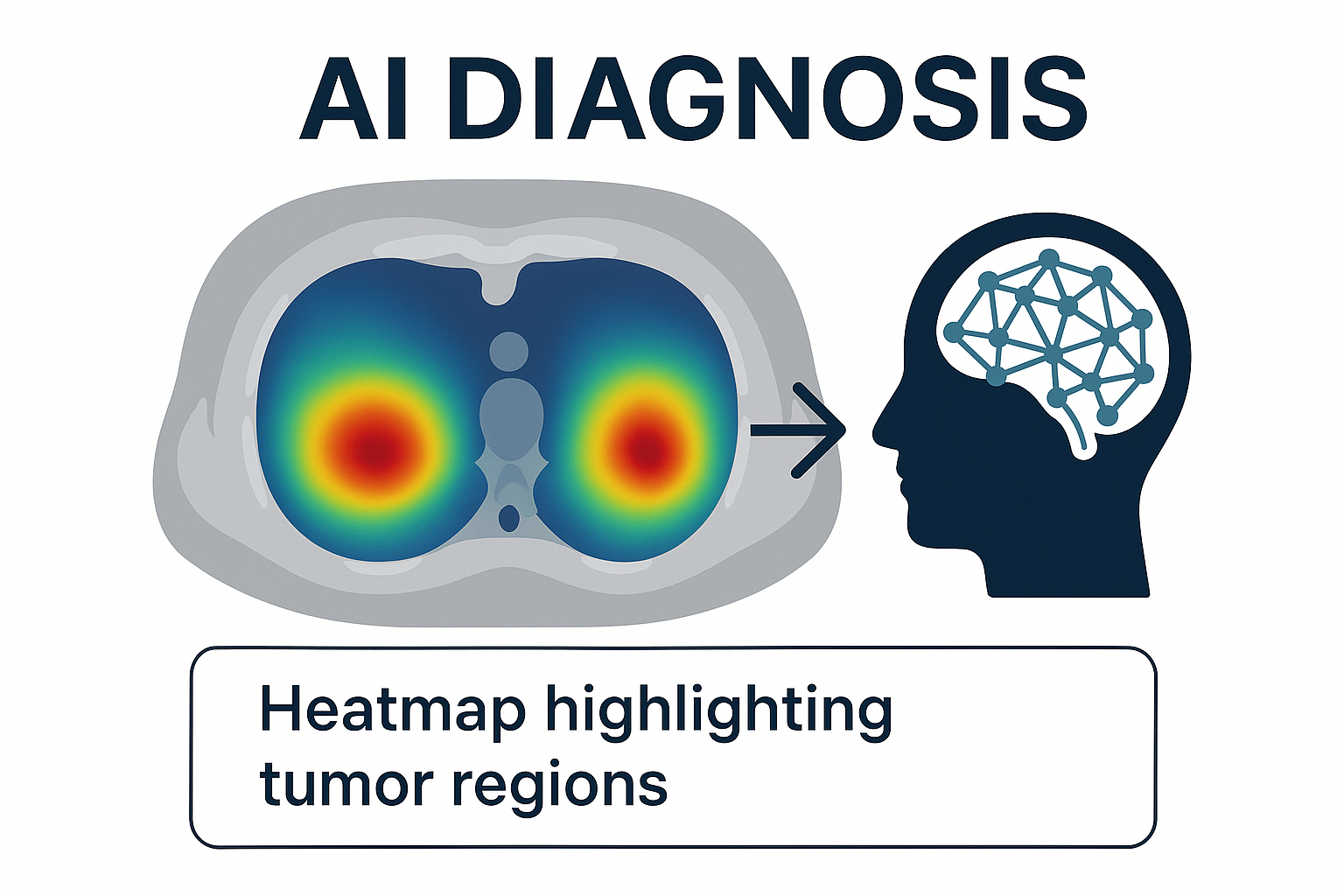

Ilustração de sistema de XAI em diagnóstico médico mostrando mapa de calor

A XAI em medicina distingue-se por sua aplicação em contextos de alto risco e responsabilidade, onde decisões incorretas podem afetar diretamente a vida dos pacientes17. Diferentemente de outros domínios, a explicabilidade médica deve atender simultaneamente às necessidades de múltiplos stakeholders: médicos especialistas, enfermeiros, gestores hospitalares, pacientes e reguladores89.

Os sistemas de diagnóstico médico baseados em IA enfrentam o dilema fundamental da "caixa-preta", onde modelos complexos como redes neurais convolucionais (CNNs) alcançam alta performance mas carecem de interpretabilidade intrínseca310. Esta opacidade é particularmente problemática em medicina, onde a justificativa das decisões é essencial para responsabilidade médica e consentimento informado1112.

A interpretabilidade em sistemas de diagnóstico médico pode ser classificada em duas dimensões principais:

Interpretabilidade Temporal: Inclui explicações pré-hoc (modelos intrinsecamente interpretáveis) e post-hoc (técnicas aplicadas após o treinamento)1314. Em medicina, técnicas post-hoc como LIME e SHAP são amplamente utilizadas para explicar modelos complexos sem sacrificar performance1315.

Interpretabilidade por Escopo: Abrange explicações locais (decisões específicas para pacientes individuais) e globais (comportamento geral do modelo)1014. Explicações locais são particularmente valiosas em diagnóstico médico, permitindo compreender por que um paciente específico recebeu determinado diagnóstico1316.

Os mapas de calor representam a técnica mais intuitiva e amplamente adotada para explicabilidade em diagnóstico por imagem médica35. Estas visualizações destacam regiões anatômicas que mais contribuíram para a decisão diagnóstica, permitindo validação clínica direta1615.

O Grad-CAM emergiu como padrão-ouro para explicabilidade em CNNs médicas, utilizando gradientes para identificar regiões discriminativas em imagens1615. Esta técnica calcula a importância de cada região através da análise dos gradientes da predição em relação aos mapas de características das camadas convolucionais16.

Estudos demonstram que o Grad-CAM supera técnicas anteriores como CAM na precisão de localização de patologias em radiografias torácicas3. A implementação do Grad-CAM++ oferece refinamentos adicionais, proporcionando explicações mais detalhadas especialmente em casos onde múltiplas regiões contribuem para o diagnóstico15.